Zero-shot Voice Conversion

기술의 개요

- 음색 변환(voice conversion) 기술은 음성에서 발화의 내용과 같은 화자(소스) 독립적인 언어적 정보는 유지한 채, 음색과 같은 화자(타겟) 종속적인 비언어적 정보를 원하는 정보로 바꾸는 기술을 의미합니다. 음성 합성(speech synthesis) 시스템이나, 발성 장애를 가진 개인을 위한 음성 보조기, 음성 데이터 생성과 같은 응용분야 중 개인적 특성을 분영하는 목적으로 활용 가능합니다.

- 초기의 음색 변환 기술들은 일반적으로 훈련 데이터로 병렬 데이터(parallel data)를 사용하였습니다. 여기서, 병렬 데이터란 원 화자와 특정 화자의 음성 데이터가 동일한 언어적 정보가 쌍으로 구성된 것을 가리킵니다. 이러한 병렬 데이터는 현실적으로 많은 양의 데이터를 모으는 것에는 한계가 있기 때문에, 현재는 비병렬 데이터(non-parallel data)를 활용한 음색 변환 기술이 많이 연구되고 있습니다.

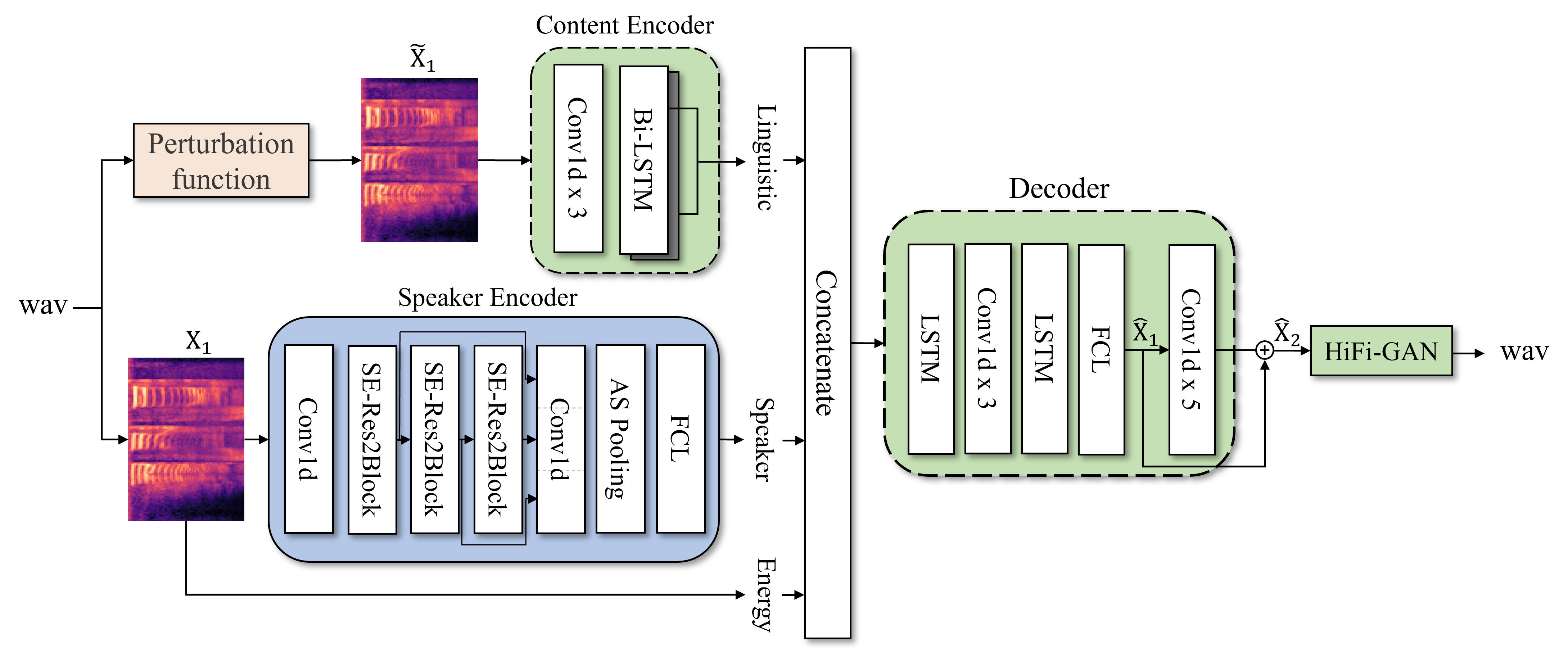

- 오토인코더(autoencoder)모델 구조를 활용한 음색변환 방법의 경우, 은닉층(bottleneck) 차원을 조절하면서 음성 정보에 포함된 언어정보와 화자 정보를 분리합니다. 그러나 이러한 방법은 은닉층 차원에 따라 모델의 성능이 매우 민감하게 좌우 된다는 단점이 있습니다. 예를 들어, 은닉층 차원이 매우 좁을 경우 음성에 존재하는 화자 정보를 제거할 뿐만 아니라 언어정보까지 일부 손상될 수 있으며, 손상된 언어정보를 이용하여 음성을 복원할 경우 음성의 품질이 저하될 수 있습니다. 반대로 은닉층 차원이 매우 넓을 경우 음성에 언어정보와 화자정보를 제대로 분리할 수 없어, 복원된 음성의 화자 유사도가 낮아질 수 있습니다.

- 이러한 단점을 해결하기 위해, 정보 교란 방법(information perturbation)을 적용할 수 있습니다. 정보 교란 방법이란 음성에 존재하는 화자 정보를 왜곡시키는 방법입니다. 이러한 방법을 오토인코더 모델 구조에 적용할 경우, 은닉층 차원에 따른 정보 분리 방법을 사용하지 않을 수 있으며, 정보 교란 방법으로 언어정보는 손상되지 않기 때문에 음성의 품질과 화자 유사도 간의 trade-off 관계를 해결할 수 있습니다. 현재 다양한 생성 모델 기반의 음색 변환 기술들이 연구되고 있으며, 대표적인 방법으로는 diffusion 모델들을 활용한 음색 변환 기술들이 연구되고 있습니다.

관련 github 페이지 바로가기

Zero-shot Speech Synthesis (Text-to-Speech)

기술의 개요

- 음성 합성이란 자연어를 입력으로 받아 음성을 생성하는 기술을 의미합니다. 신경망 기반의 음성 합성 기술은 크게 2단계로 나누어져 있습니다. 자연어를 음향 특징 벡터로 생성하는 음향 모델과 음향 특징 벡터를 음성 파형으로 변환하는 보코더 모델이 있습니다. 우리는 특히, 자연어를 음향 특징 벡터로 생성하는 음향 모델을 주로 연구하고 있습니다.

- 기존의 음성 합성 모델은 단일 화자에 대해서 자연스러운 억양과 정확한 발음을 발성하는 음성을 생성하는데 주목하였습니다. 하지만 최근에 연구되고 있는 음성 합성 모델은 단일 화자에 대해서 높은 음성 합성 성능을 보일 뿐만 아니라 다수의 화자에 대해서 음성 합성이 가능한 다화자(Multi-Speaker) 음성 합성 모델이 연구되고 있습니다. 더 나아가 학습 중 보지 못한 화자(Unseen Speaker)에 대해서 음성을 합성할 수 있는 Zero-Shot Multi-Speaker 음성 합성 모델이 많이 연구되고 있습니다.

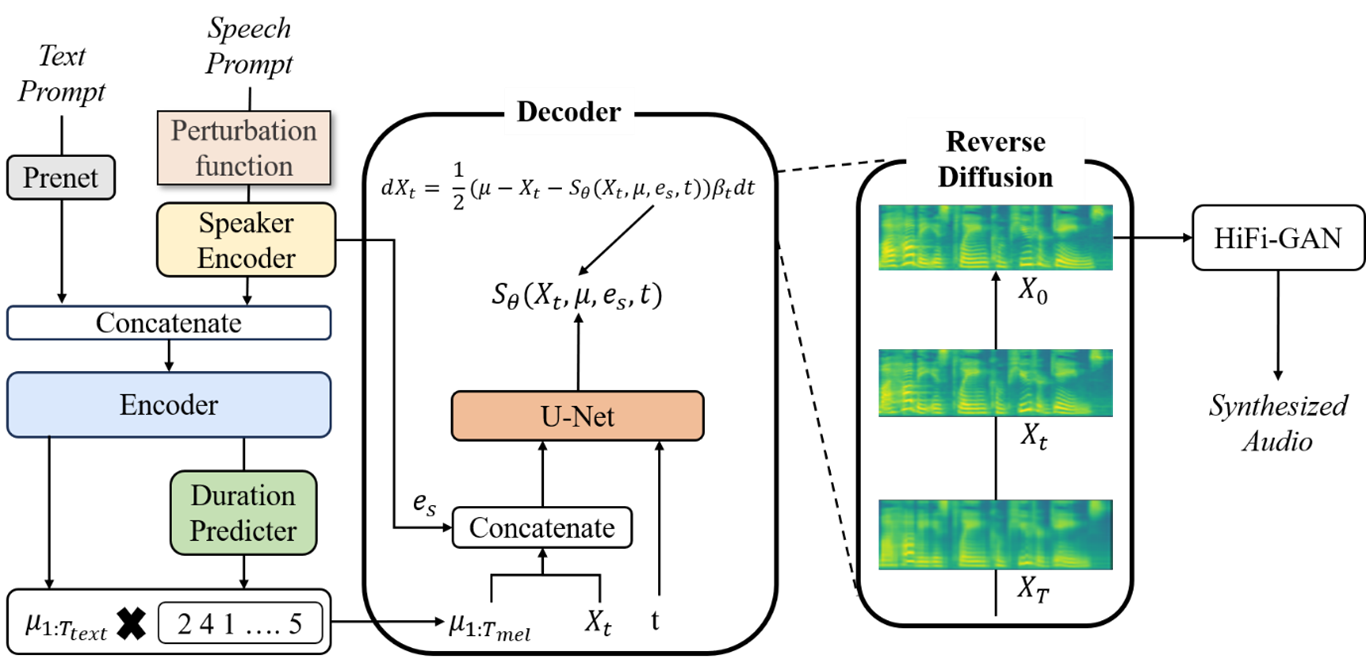

- 우리는 다양한 분야에서 높은 성능을 보이는 Diffusion 모델을 바탕으로 Zero-Shot Multi-Speaker 음성 합성 모델에 대해서 연구하고 있습니다. Diffusion 모델은 확산의 개념을 이용하여 데이터를 생성하는 방법으로 크게 2가지 단계로 나뉩니다. 데이터의 분포에 점진적으로 노이즈를 주어 다루기 쉬운 데이터 분포로 변환하는 Forward Process와 다시 원본 데이터로 복원시키는 Backward Process를 통해 데이터를 생성하게 됩니다. 이러한 Diffusion 기반의 음성 합성 모델 중 가장 성공적인 모델로는 Grad-TTS가 있습니다.

- Grad-TTS는 트랜스포머(Transformer) 기반의 텍스트 인코더와 Diffusion 기반의 디코더로 구성된 음성 합성 모델로, 현재 단일 화자에 대해서 높은 음성 합성 성능을 보이는 모델입니다. 우리는 이러한 Grad-TTS를 개선하여 Zero-Shot Multi-Speaker 환경에서 높은 성능을 보이는 음성 합성 모델을 개발하고 있습니다. 또한, 다양한 Diffusion 모델들을 활용한 음성 합성 기술들을 연구하고 있습니다.

Speaker Recognition

기술의 개요

- 화자인식이란 음성 신호로 부터 화자를 식별할 수 있는 특징을 추출하여 입력 발화가 어느 화자의 발화인지 판별하는 기술을 의미합니다. 화자인식은 입력된 발화가 등록된 화자 중 어느 화자와 가장 유사한지 판단하는 화자 식별 기술과 두 쌍의 발화가 같은 화자의 발화인지 판단하는 화자 검증 기술로 구성됩니다.

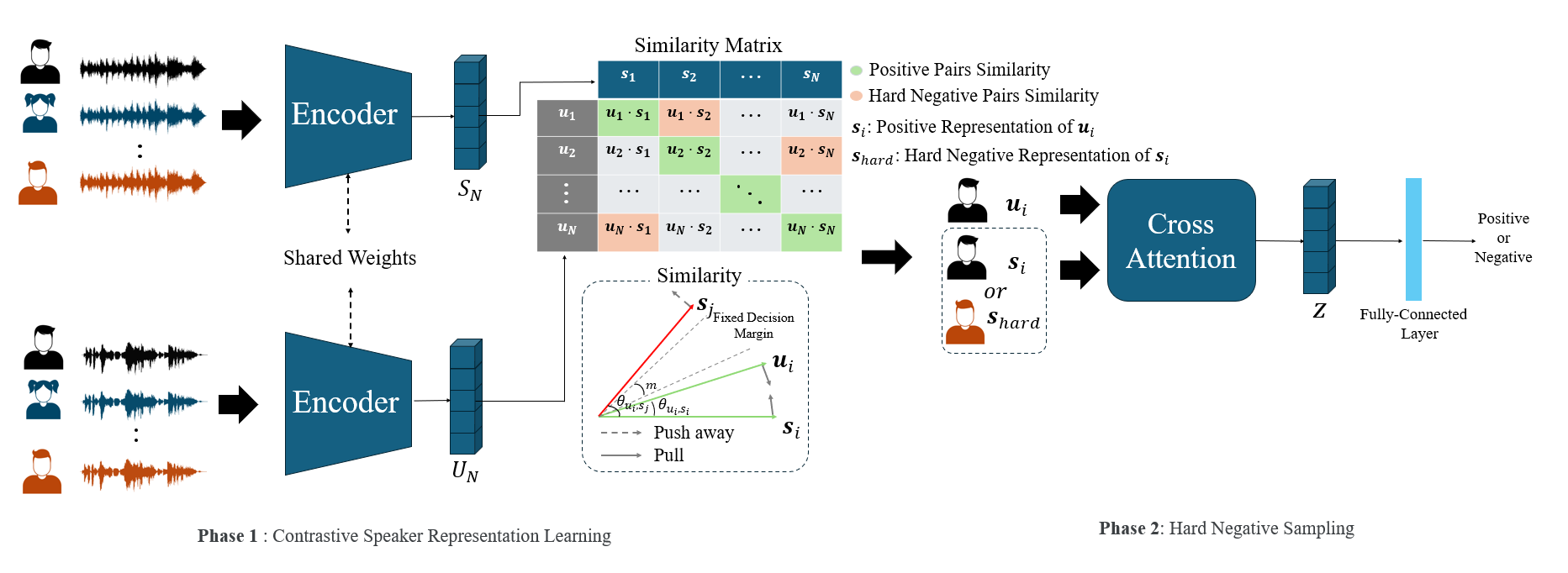

- 기존의 화자인식은 딥러닝 모델을 cross-entropy, AMSoftmax, AAMSoftmax등와 같은 손실함수을 통해 화자를 식별하는 분류 접근 방식과 contrastive loss, triplet loss와 같은 손실함수를 통해 representation 간의 관계을 학습하는 대조학습 접근 방식 등의 방법이 존재합니다. 이러한 방식 중에서 우리는 대조학습을 활용한 화자인식 연구를 하고 있습니다.

- 최근 널리 활용되는 대조학습 기법 중에는 대량의 데이터셋에 대해 InfoNCE와 같은 손실함수를 활용하여 contrastive lanaguage image pretraining (CLIP)와 같이 one-to-many간의 representation간의 관계를 학습하는 연구들이 많이 제안되고 있습니다. 이러한 기법이 zero-shot classfication에서 state-of-the-art을 달성하는등 높은 성능을 달성하고 있다는 점에서, 우리는 CLIP의 학습 기법을 기반으로 voxceleb dataset을 활용해 강건한 화자인식 모델을 학습하는 프레임워크를 개발하는 연구를 수행합니다.

- 이와 같이 화자인식은 다양한 딥러닝 모델 및 학습기법을 응용한다면, 더욱 강건한 모델을 학습할 수 있습니다. 우리는 실제로는 다른 화자의 발성이지만 유사한 특징을 가지고 있어 오인하기 쉬운 하드 네거티브 샘플에 대응하기 위한 하드 네거티브 샘플링 기법을 활용하는 등 다양한 화자인식 연구를 수행합니다.